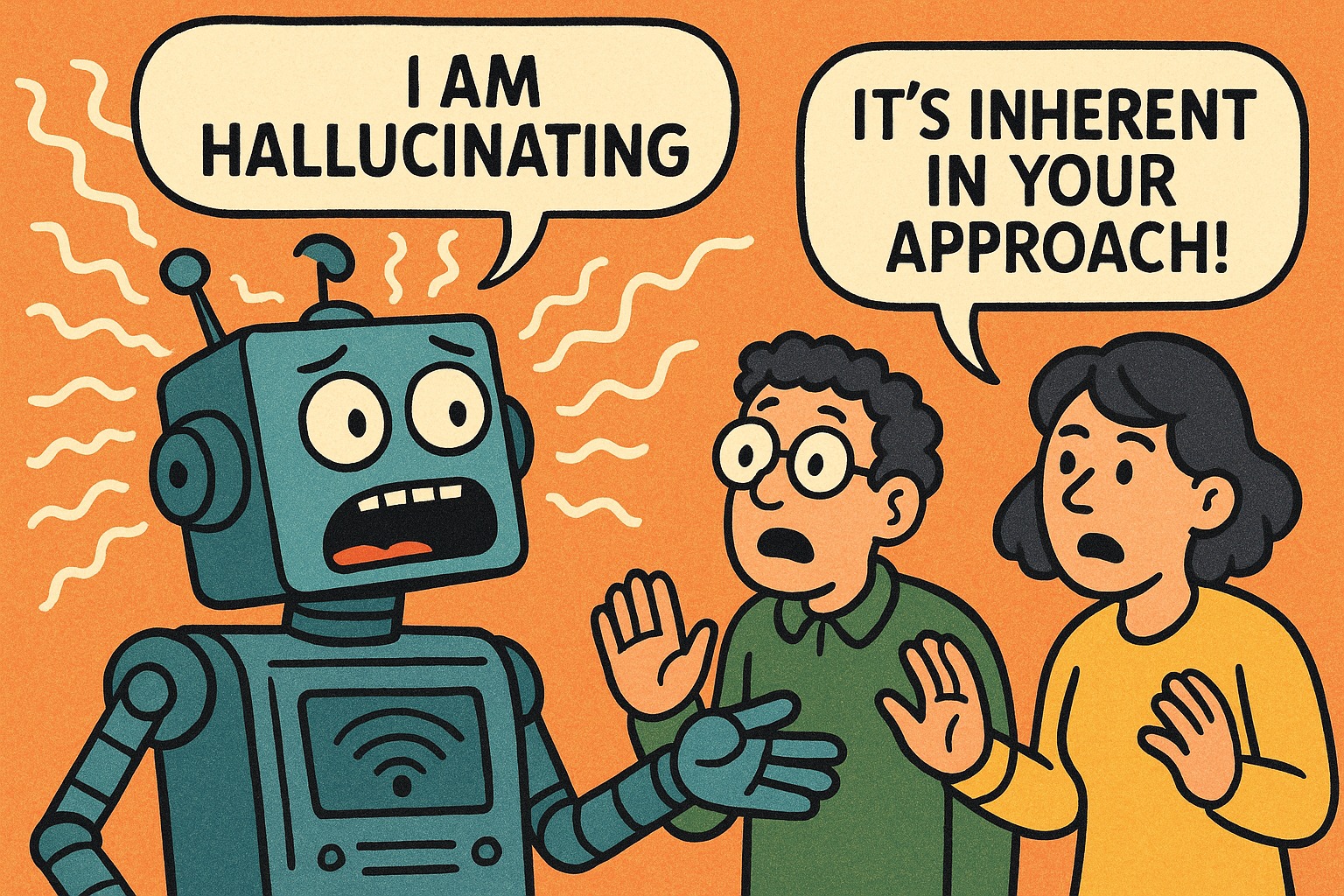

Een recent rapport van onderzoekers van OpenAI en Georgia Tech schetst een verontrustend maar helder beeld van waarom grote taalmodellen (Large Language Models, LLM) blijven hallucineren, oftewel: geloofwaardig klinkende, maar feitelijk onjuiste uitspraken blijven doen. Volgens de auteurs komt dit vanwege fundamentele kenmerken van de huidige trainings- en evaluatiemethoden.

Actueel

'Meld je aan voor de nieuwsbrief'

'Abonneer je nu op een of meerdere van onze nieuwsbrieven en blijf op de hoogte van onze activiteiten!'

Aanmelden